服务内容

1)高性能计算数值模拟

2)高性能计算应用程序移植、优化和研发

3)高性能计算应用软件开发

典型案例一

中国石油大学提供的炮域并行版本程序,模拟时对单节点的内存依赖比较大,计算资源使用不充分。天津超算中心将程序进行拓扑优化,实现对模型的拆分并分散到不同进行计算,使其可以在不增加内存的情况下,充分使用资源。

为验证优化版本的正确性、测试程序的计算时间和较原程序的加速情况,通过简单算例进行测试,并已反馈给东方地球物理公司采集中心。

此次测试的程序版本主要包括两个:

1、 初始版本:该程序由北京石油大学提供,采用炮间MPI并行方法;

2、 拓扑优化版本:该程序基于初始版本的程序,为解决内存问题,采用MPI拓扑技术拆分每炮的模型,分散到不同进程进行计算。

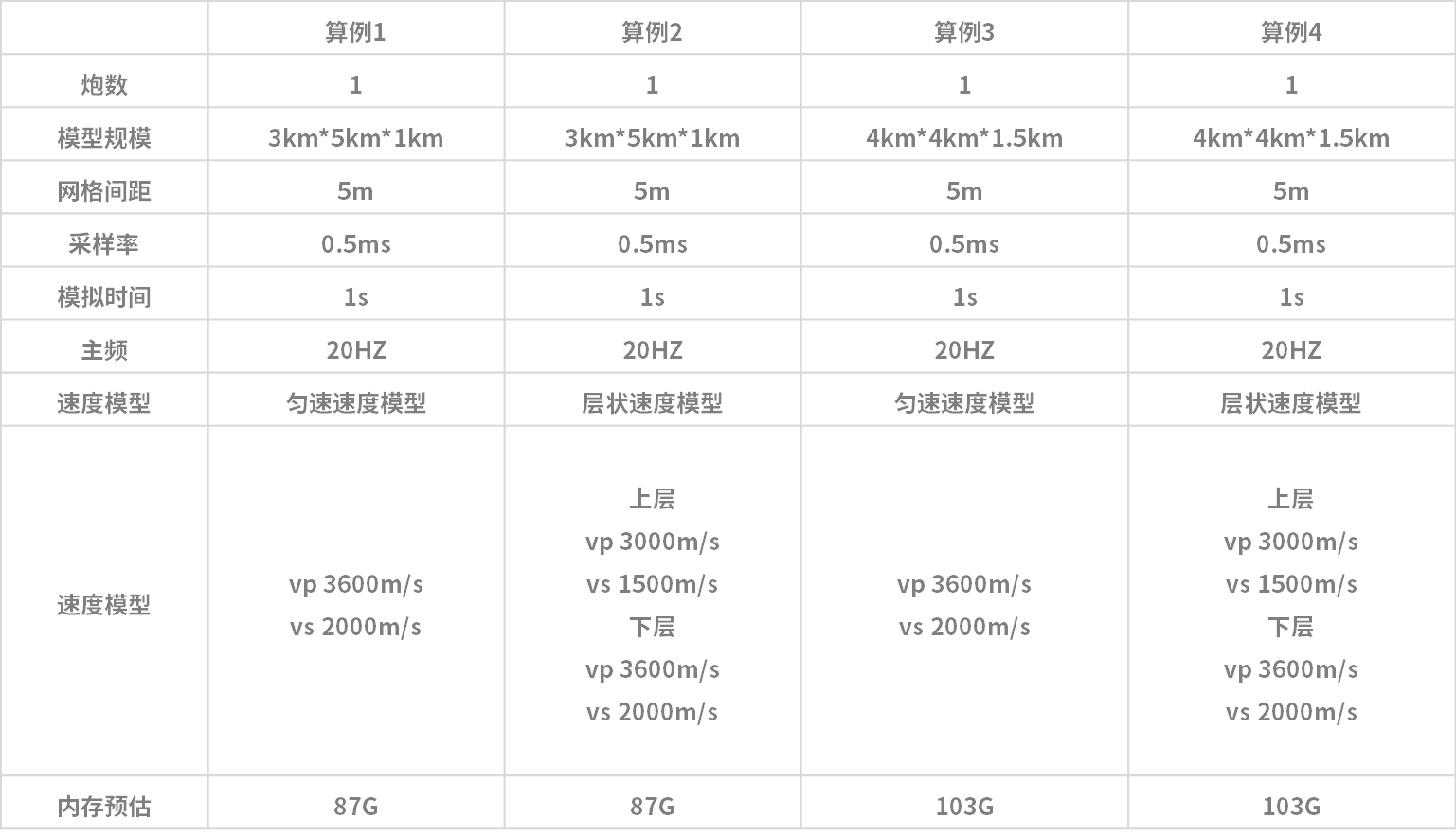

表 测试算例描述

注:为满足稳定性条件的需求,在网格间距5m的情况下,需调整采样率为0.5ms该测试在中心HPC系统进行,单节点配置2*E5 2690v4 cpu 共28核,128G内存。

对于初始版本的程序使用1个cpu核进行计算;

对于优化版本的程序使用25个cpu核进行计算。

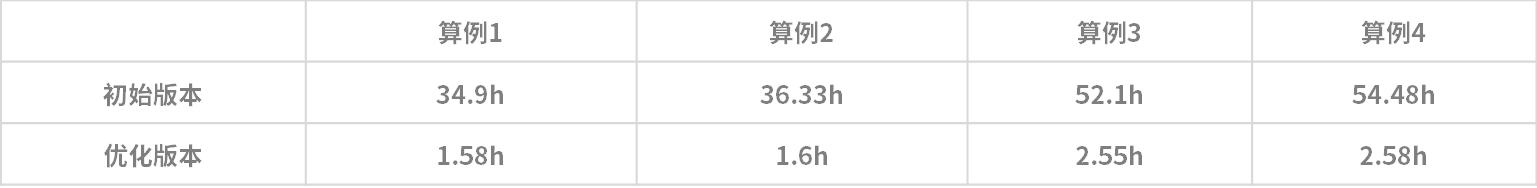

两个版本的程序对于两个算例,模拟计算1s的测试结果如下表所示:

根据以上测试结果所示,经过优化后的版本,在处理相同算例,计算效率提高了20余倍,加速比约为84%。

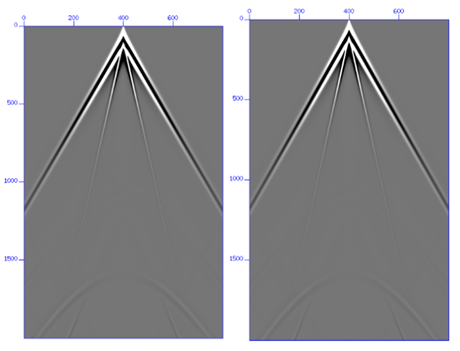

对于两个版本程序,抽取层状模型的x分量地震记录中间线的计算结果进行对比:

左图:原始程序的地震记录;右图:优化程序的地震记录

经对比可发现,优化前后的程序计算结果相同,具有可信度。

典型案例二

LASG/IAP气候系统海洋模式(LICOM3):由中国科学院大气物理研究所大气科学和地球流体力学数值模拟国家重点实验室(LASG)研制、发展、建立的模块化耦合气候模式中的海洋分模式(第三版)。

存在问题:

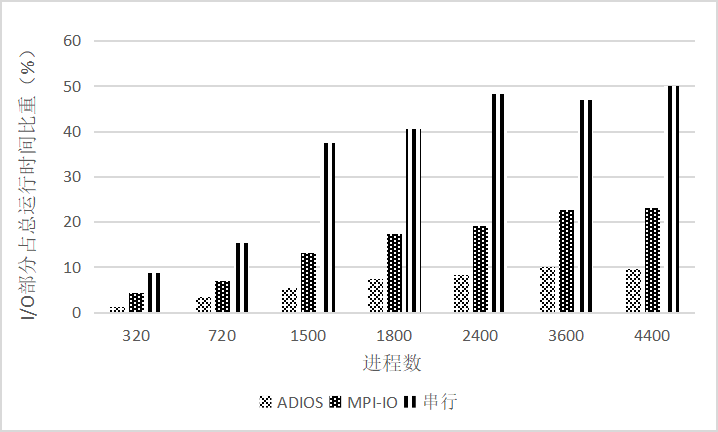

在天河系统,水平10 公里分辨率下,测试得到:

• 2400 并行度时,串行I/O 部分占总运行时间的48.2%;

• 4400 并行度时,串行I/O 部分占比可达到50%以上;

IO时间占比随进程数的增加而不断增大,成为程序应用瓶颈;

优化工作:

分别采用MPIIO和ADIOS方法对程序的IO进行了并行优化,获得了较好的IO效率提升,并进一步对OST数、聚合时步、不同IO传输方法等对输出效率的影响进行了研究,以提出更有效的IO优化机制。

优化效果:

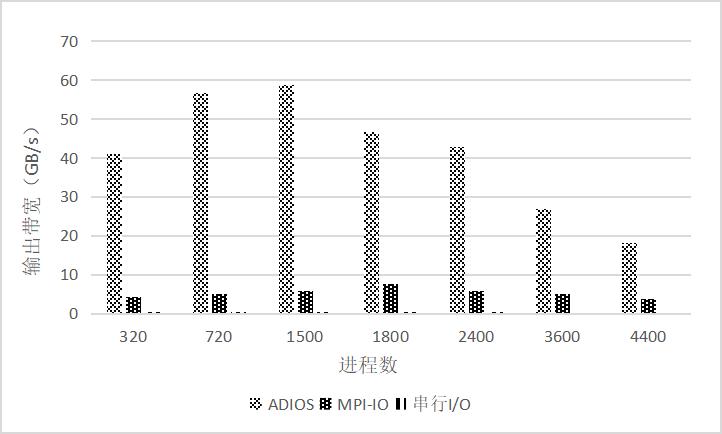

图为ADIOS(POSIX)、MPI-IO和串行I/O在各并行度下的输出带宽

优化结果:最高输出带宽

• ADIOS约为58.68GB/s,约为原值279倍;

• MPI-IO约7.75GB/s,约为原值38.75倍;

图为ADIOS(POSIX方法)、MPI-IO和串行I/O在各并行度下的I/O时间占比

优化结果:IO时间占比

• 优化后的值远远低于原串行模式下的值;

ADIOS约为其1/5;MPI-IO则约为其1/2;

典型案例三

潮流潮位的数值预报已广泛应用于洪水预报、航运预警等水流模拟相关领域,尤其随着近几年计算机技术的进步,使得人们对于潮流潮位的精确模拟逐步成为现实。但随着模拟范围、内容与精度要求的不断增长,提高计算效率已成为模型应用的迫切需求。

天津超算中心在现有研究成果的基础上,建立了适用于港口、海岸和近海工程领域的“自由表面的浅水流动”问题的仿真模型,将现有CFD领域先进技术引入其中,同时基于超级计算平台采用CPU+GPU异构的并行策略实现了潮流潮位数值算法的并行优化,在提升求解精度的同时保证计算效率满足数值预报的要求。

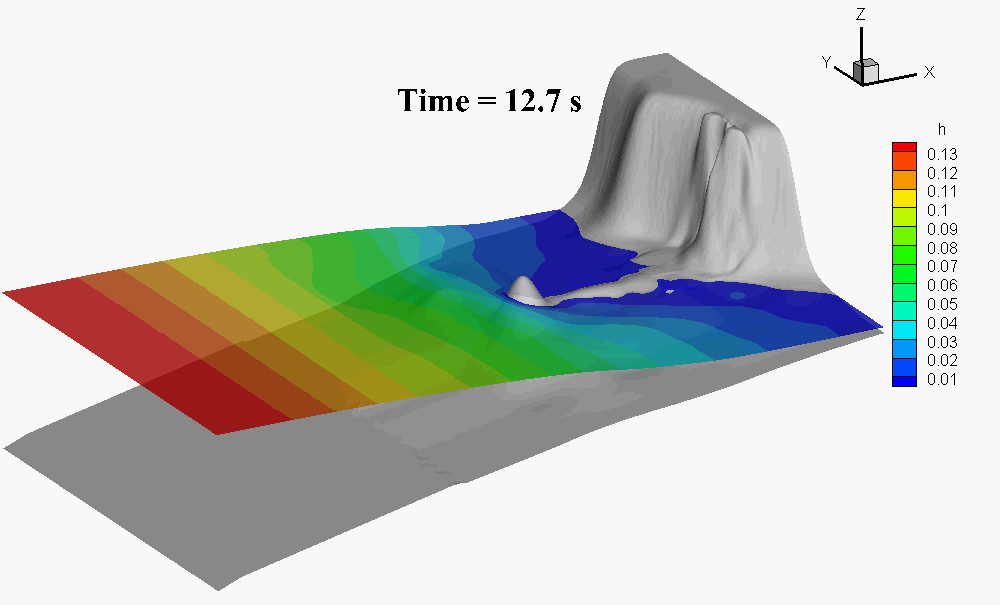

图 海啸近岸传播增水模拟